Retrouvez l’article original de « Village de la Justice », rédigé par Véronique Dahan et Jérémie Leroy-Ringuet ici.

Chat-GPT, Dall·E 2, Stable Diffusion… Les créations de l’intelligence artificielle sont-elles des œuvres protégeables ? Qui pourrait prétendre en être l’auteur ? Mais surtout, les auteurs d’œuvres préexistantes ont-ils des droits contre l’utilisation de leur style et de leurs œuvres par l’IA ?

L’utilisation de l’intelligence artificielle (IA) par les entreprises, en particulier pour leur communication, est de plus en plus répandue. Des logiciels tels que Stable Diffusion, Midjourney, Craiyon, mais surtout Dall·E 2, développé par OpenAI et lancé en janvier 2022, permettent de créer des images à partir d’instructions en langage naturel (le « text-to-image »). Il est également possible de créer de la musique ou du texte de la même manière, par exemple en demandant à un logiciel de rédiger une description d’un paysage de fjords au coucher du soleil, avec des outils tels que le robot Chat-GPT, lancé en novembre 2022 par OpenAI.

Au-delà de leur aspect ludique, les applications artistiques ou professionnelles possibles de ces logiciels sont assez variées : illustration d’un article, création de marque, de logo, de slogan, de jingle, de textes pour un site Internet, pour un support publicitaire ou pour un post sur les réseaux sociaux, etc., et bientôt peut-être des œuvres littéraires complexes ou des films. Les artistes s’en sont emparé pour développer une forme d’art appelé l’Art IA, le Prompt Art ou encore le GANisme (en référence aux réseaux antagonistes génératifs ou Generative Adversarial Networks) et, parfois, en transformant en NFT les résultats obtenus [1].

L’IA peut donc être d’une aide significative, que ce soit en fournissant des contenus prêts à emploi ou de simples idées de départ à développer par des moyens « humains » ou en utilisant d’autres logiciels plus « traditionnels ». L’image, le texte ou le groupe de mots obtenu avec une économie de temps et d’efforts peut ainsi être retravaillé et perfectionné, les résultats obtenus étant encore aujourd’hui parfois imparfaits.

Pour produire une image sur commande, un logiciel a besoin d’être nourri en images préexistantes et en métadonnées sur ces images (ce qu’on appelle le « deep-learning »).

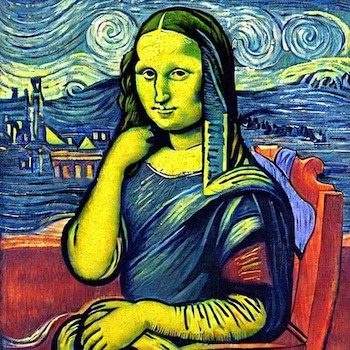

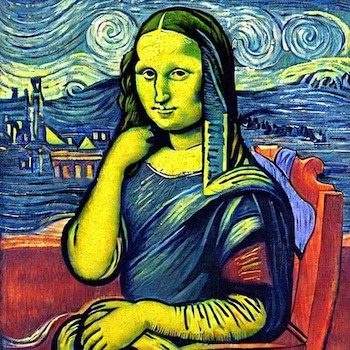

Par exemple, pour pouvoir créer une image de Mona Lisa dans le style de Van Gogh, le logiciel doit avoir été nourri 1° d’images reproduisant la Joconde de Léonard de Vinci, 2° de l’information que ces images représentent Mona Lisa, 3° d’images de tableaux de Van Gogh et 4° de l’information que ces images représentent des tableaux de Van Gogh. Plus le logiciel dispose d’informations fiables, plus le résultat sera probant :

(Image créée avec Stable Diffusion.)

Il serait également possible, par exemple, de créer des images n’incorporant pas d’œuvres préexistantes mais se référant d’une manière générale au style d’artistes dont les œuvres sont soit dans le domaine public soit encore protégées (c’est-à-dire dont l’auteur est vivant, ou est mort depuis moins de soixante-dix ans), comme l’image d’une sculpture dans le style de Jeff Koons.

Le même principe vaut pour les textes : si l’on demande à un générateur de textes de créer un dialogue à la manière de Shakespeare entre deux avocats fiscalistes qui se rencontrent devant une bouche du métro londonien et parlent du Brexit, le texte reproduira les archaïsmes anglophones typiques du théâtre élisabéthain.

Comme toute nouveauté technologique, l’utilisation de ces logiciels soulève de nombreuses questions juridiques.

L’objet de cet article est de répondre en particulier à la question centrale qui est : à qui appartiennent les droits (s’ils existent) sur les contenus générés par l’IA ?

En droit français, une œuvre est protégeable si elle est originale. L’originalité est définie comme révélant l’empreinte de la personnalité de l’auteur, qui ne peut être qu’un être humain. Il faut donc déterminer qui est l’auteur, ou qui sont les auteurs d’une image ou d’un texte créés via une instruction donnée à un logiciel. Il faut aussi déterminer qui peut en être titulaire des droits puisqu’une personne qui n’est pas l’auteur peut être, par l’effet de la loi, du contrat ou par présomption, titulaire des droits d’exploitation de l’œuvre.

Dans le processus qui nous a permis de créer une version de la Joconde de Vinci dans le style de Van Gogh, plusieurs personnes pourraient, volontairement ou non, avoir contribué à la création de l’image (en être auteurs ou coauteurs) ou être titulaires des droits :

- Les auteurs des œuvres préexistantes, c’est-à-dire Léonard de Vinci et Vincent Van Gogh,

- Nous-mêmes, lorsque nous avons donné comme instruction au logiciel : « Mona Lisa dans le style de Van Gogh »,

- L’auteur du logiciel Stable Diffusion et la société exploitant le site Stable Diffusion.

Les droits des exploitants des logiciels (Stable Diffusion, Dall·E 2, Midjourney…).

Les entités exploitant les sites de Stable Diffusion, Dall·E 2, etc. revendiquent dans leurs conditions générales leur titularité sur les droits afférents à leurs logiciels. Ils sont donc en mesure d’autoriser ou d’interdire l’usage que les internautes font de leurs logiciels.

Ces logiciels contribuent au processus permettant d’obtenir des textes et images inédites, dans la mesure où ce sont ces générateurs d’images qui, dans notre exemple, ont sélectionné une atmosphère nocturne bleutée avec les spirales de La nuit étoilée plutôt que, par exemple, le décor vert et jaune de Champ de blé avec cyprès qui aurait également et peut-être mieux convenu. On peut aussi remarquer que le logiciel a choisi de relever le bras droit de Mona Lisa comme dans L’Arlésienne (Madame Ginoux) ou dans Portrait du Dr Gachet, et de la faire assoir sur une chaise qui évoque par sa couleur et la forme de ses ornements La chaise de Gauguin.

Nous ne sommes pas dans la situation d’une participation purement passive (comme le serait celle d’un pinceau pour un peintre ou d’un logiciel de traitement de texte pour un écrivain) : c’est précisément la part d’« autonomie » des logiciels d’IA qui jette le trouble dans la conception traditionnelle du droit d’auteur. Néanmoins, la contribution du logiciel se fait de manière automatisée et, à notre sens, l’usage technique d’un logiciel pour créer une image ou un texte ne donne au propriétaire du logiciel aucun droit sur l’image ou sur le texte : en l’absence d’une intervention humaine sur le choix des couleurs et des formes, aucun droit d’auteur ou de coauteur ne peut être revendiqué au nom de l’exploitant du logiciel.

Les conditions d’utilisation de ces générateurs de textes et d’images le confirment. Dans le cas de Dall·E 2, les Terms of use prévoient expressément qu’OpenAI transfère à l’utilisateur tous les droits sur les textes et les images obtenus et demande même que le contenu soit attribué à la personne qui l’a « créé » ou à sa société.

Stable Diffusion fait de même en octroyant une licence de droits d’auteur perpétuelle, mondiale, non exclusive, gratuite, libre de redevances et irrévocable pour tous types d’usage, y compris commercial. Mais en l’absence, selon nous, de tout droit transférable, ces dispositions nous semblent constituer de simples précautions.

D’autres sites comme Craiyon ne prévoient pas de cession de droits au bénéfice de l’utilisateur sur les résultats obtenus mais encadrent seulement l’usage du logiciel, en prévoyant des licences spécifiques dans le cas d’usages commerciaux des images créées. Le caractère payant de ces licences dépend notamment du chiffre d’affaires de la société utilisant les images créées sur son site. On comprend qu’il s’agit davantage pour Craiyon de monétiser l’usage d’un logiciel qui a représenté un investissement pour la société que de déterminer les contours d’une cession de droits d’auteur.

Il est donc essentiel, pour toute personne qui souhaite utiliser, à titre commercial ou non, les images créées via des outils d’IA, de vérifier si la société exploitant le site où il les crée lui en donne les droits et à quelles conditions, même s’il ne s’agit pas de conditions relatives à la titularité de droits sur les contenus.

Les droits de la personne qui utilise le logiciel.

Dès lors que l’apport créatif de la personne qui donne des instructions au générateur d’images ou de textes est limité à la production d’une idée mise en œuvre par le logiciel, et que les idées ne sont pas protégeables par le droit d’auteur, il est douteux que la qualité d’auteur soit reconnue à cette personne.

C’est d’autant plus vrai que, lorsqu’une instruction est donnée au logiciel, le résultat de la mise en forme de l’instruction est inconnu tant qu’il n’apparaît pas à l’écran, et que même des instructions très précises peuvent donner des résultats très variés – comme ce serait d’ailleurs le cas si l’on donnait ces instructions à des êtres humains. Puisque l’utilisateur du logiciel ne conçoit pas mentalement, à l’avance, l’image obtenue, il est difficile d’avancer que cette image porte « l’empreinte de sa personnalité ».

C’est particulièrement évident dans le cas d’instructions succinctes ou comprenant des termes abstraits.

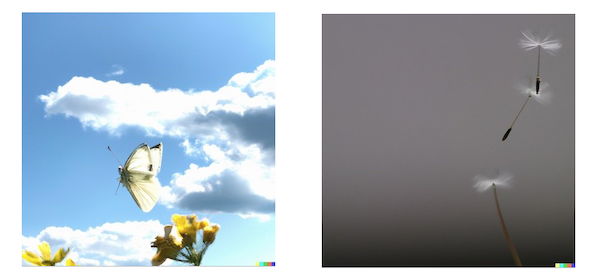

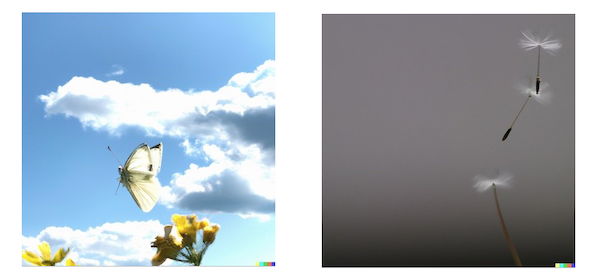

Ainsi, les résultats obtenus par nous sur Dall·E 2 en donnant comme instruction « l’insoutenable légèreté de l’être » ont pu présenter des images, certes évoquant la légèreté, mais aussi différentes visuellement – et donc inattendues et déconnectées de nos « personnalités » – que les suivantes :

(Images créées avec Dall·E 2)

Mais surtout, on pourrait aller jusqu’à dénier la qualification d’œuvre de l’esprit aux images et aux textes créés par l’IA. En effet, si le code de la propriété intellectuelle (CPI) ne définit pas ce qu’est une œuvre, il n’accorde la protection du droit d’auteur qu’à des « œuvres de l’esprit » créées par des humains. Faute d’action positive créatrice de la part d’un humain entre le moment où les instructions sont données et celui où les résultats apparaissent à l’écran, on pourrait avancer qu’aucun « esprit » n’est mobilisé, donc qu’aucune « œuvre de l’esprit » protégeable par le droit d’auteur n’est créée. Pour cette raison, les auteurs de ces logiciels et les sociétés les exploitant ne pourraient pas prétendre à la qualité d’auteur ou de coauteur.

S’ils ne sont pas des « œuvres de l’esprit », les textes et images créés par l’IA seraient alors des biens immatériels de droit commun comme peuvent l’être des créations non originales. Ils sont appropriables non pas par le droit d’auteur (du seul fait de leur création, article L. 111-1 du CPI) mais par la possession (article 2276 du code civil) ou par le contrat (conditions générales octroyant la propriété à l’utilisateur).

Il s’agit alors de créations libres de droit, appartenant au domaine public alors même qu’elles auraient pu être considérées comme originales et protégeables si elles avaient été créées de la main de l’homme.

Cela fait écho à d’autres types d’« œuvres » sans auteur comme les peintures du chimpanzé Congo ou les célèbres selfies pris en 2008 par un macaque. Les juridictions américaines avaient décidé que l’autoportrait réalisé par un singe qui s’était emparé d’un appareil photo et avait déclenché l’obturateur n’était pas une œuvre protégeable puisqu’il n’a pas été créé par un humain, sujet de droits.

Si la question s’était présentée devant un tribunal français, celui-ci aurait très certainement jugé que ce selfie n’est même pas une « œuvre de l’esprit » au sens du CPI.

En revanche, dès lors que le résultat obtenu est retravaillé et qu’un apport personnel formel transforme ce résultat, la qualification d’œuvre de l’esprit peut être retenue, mais uniquement en raison de la modification originale apportée au résultat produit par le logiciel. Ce cas de figure est d’ailleurs prévu dans la Sharing & Publication Policy de Dall·E 2 qui demande à ses utilisateurs qui modifieraient les résultats obtenus de ne pas les présenter comme ayant été entièrement produit par le logiciel ou entièrement produit par un être humain, ce qui est davantage, de sa part, une règle éthique, de transparence, qu’une exigence juridique.

L’Office américain du Copyright [2] a récemment publié des lignes directrices en ce sens, avec une portée clairement juridique : il annonce qu’il refusera la protection pour les contenus, ou les parties d’œuvres créés exclusivement par l’IA et ne l’accordera éventuellement que pour les éléments sur lesquels un être humain est intervenu [3].

Les droits des auteurs des œuvres préexistantes.

En droit français, une œuvre nouvelle qui incorpore une œuvre préexistante sans la participation de son auteur est dite « composite » [4]. Si les œuvres préexistantes sont dans le domaine public, comme celles de Vinci et de Van Gogh, leur libre utilisation est permise (sous réserve de l’éventuelle opposition du droit moral par les ayants droit). En revanche, incorporer sans autorisation une œuvre préexistante toujours protégée constitue un acte de contrefaçon.

Dans notre exemple, nous considérons que la Mona Lisa dans le style de Van Gogh ne peut pourtant pas être qualifiée d’œuvre composite puisqu’elle ne peut pas être une « œuvre de l’esprit ». Cela ne veut pourtant pas dire que les auteurs d’œuvres préexistantes ne disposent pas de droits sur, ou contre, les textes ou images créées en réutilisant leurs styles ou leurs œuvres.

En effet, si l’on remplace notre Joconde par une image obtenue, par exemple, en entrant les instructions : « Guernica de Picasso en couleurs », on obtiendra une image qui intègre et modifie une œuvre préexistante. Or les œuvres de Picasso ne sont pas dans le domaine public. Les ayants droit du peintre disposent donc de droits sur l’image qui serait ainsi créée. Ils doivent pouvoir autoriser ou interdire non seulement l’exploitation de l’image obtenue et en demander la destruction, mais peut-être aussi interdire ou autoriser l’usage des œuvres de Picasso par le logiciel – qui, rappelons-le, puise dans sa « connaissance » d’un nombre d’images considérable, comprenant nécessairement les reproductions des œuvres de Picasso, pour répondre aux instructions qui lui sont données.

La production et la publication par un utilisateur d’un « Guernica en couleurs » pourrait donc constituer une contrefaçon ; mais l’intégration de Guernica dans la base de données du logiciel pourrait également, à elle seule, constituer un acte contrefaisant.

En effet, les sites proposant des générateurs d’images par IA nourries d’œuvres protégées pourraient théoriquement se voir considérées comme contrefacteurs par le CPI qui sanctionne le fait « d’éditer, de mettre à la disposition du public ou de communiquer au public, sciemment et sous quelque forme que ce soit, un logiciel manifestement destiné à la mise à disposition du public non autorisée d’œuvres ou d’objets protégés » [5].

Le caractère « manifeste » de la mise à disposition, et la qualification de « mise à disposition » elle-même, pourraient être discutés.

Mais c’est surtout la directive 2019/790 du 17 avril 2019 qui vient en aide aux exploitants de générateurs d’images et de textes en offrant une sécurisation de leur usage d’œuvres préexistantes protégées.

La directive a imposé une harmonisation européenne de l’exception de « fouille de textes et de données » (text and data-mining, articles 3 et suivants). Elle encadre l’exploitation à toutes fins, y compris commerciales, d’œuvres protégées pour en extraire des informations, notamment dans le cas des générateurs de textes et d’images. Mais la directive prévoit également une possibilité pour les titulaires de droits sur ces œuvres d’en autoriser ou interdire l’usage, hors finalités académiques. Une telle autorisation peut difficilement être préalable et les exploitants, OpenAI, par exemple, mettent donc en place des procédures de signalement de création de contenu contrefaisant (article 3d des conditions générales d’OpenAI). Mais les artistes se plaignent déjà de la complexité qu’il y a à obtenir un tel retrait alors qu’ils font face à une profusion d’images imitant leur style, certains ayant remarqué qu’Internet proposait davantage d’images créées par IA imitant leur style que d’images de leurs propres œuvres [6].

Les exploitants de ces logiciels pourraient donc se voir condamner pour contrefaçon, éventuellement sur le fondement de l’article L335-2-1 du CPI, lorsque les titulaires de droits sur des œuvres ont demandé leur retrait et que les exploitants ne se sont pas exécutés. Ils pourraient avoir à indemniser les utilisateurs des textes et images ainsi produits puisque ces derniers ne sont pas censés savoir si un titulaire a fait valoir son droit d’« opt-out ».

Le risque représenté par l’incorporation d’œuvres préexistantes a ainsi été anticipé et assumé par certains acteurs comme Adobe qui envisage d’indemniser ses clients ayant acheté des images créées par IA, en cas de réclamation des auteurs ou des ayants droit [7].

L’imitation du style des auteurs d’autres œuvres préexistantes : un acte contrefaisant ?

Les auteurs d’œuvres préexistantes peuvent subir un préjudice du fait de la multiplication de textes imitant leur style ou d’images représentant des « œuvres » qu’ils auraient pu concevoir mais qu’ils n’ont pas créées, comme notre Joconde imitant le style de Van Gogh, que Van Gogh n’a jamais peinte. Les artistes ainsi imités se mobilisent d’ailleurs en lançant des mots d’ordre du type #SupportHumanArtists. Sur quel fondement pourraient-ils s’opposer à la création de ce type de contenus et quels risques y a-t-il à produire de tels textes ou images ?

Le fondement du faux artistique semble à écarter.

Les faux artistiques sont sanctionnés en droit français par la loi « Bardoux » du 9 février 1895, toujours en vigueur. Ils se distinguent des contrefaçons au sens du CPI en ce qu’ils ne sont pas la reproduction non autorisée d’une œuvre préexistante et protégée mais l’imitation d’un style, afin d’attribuer à un auteur une œuvre qu’il n’a pas créée, ou d’associer son style avec une œuvre dont la valeur marchande est bien inférieure à celle d’une œuvre de la main de l’auteur.

Mais à strictement parler, l’image d’un ballon 3D qui imite le style de Jeff Koons, ou celle d’un tableau à la manière de Frida Kahlo ne sont pas des faux artistiques puisqu’elles sont seulement la représentation numérique d’un faux qui n’existe pas dans la réalité. Or les photographies ne sont pas concernées par la loi du 9 février 1895. Mais surtout, la qualification de faux artistique est exclue car le texte de loi, de nature pénale et donc d’interprétation stricte, réprime l’apposition d’un nom usurpé sur une œuvre ainsi que l’imitation de la signature de l’auteur. Il n’interdit donc pas la fabrication d’images « à la manière de ».

La contrefaçon est également un fondement imparfait. En toute rigueur, produire l’image d’un ballon « dans le style de » Jeff Koons en le présentant comme tel pourrait ne pas constituer une contrefaçon puisque cette image ne reproduit pas celle d’une œuvre préexistante.

L’œuvre créée « à la manière de » ne constitue donc ni un faux artistique ni une contrefaçon [8]. Il n’y a donc contrefaçon que s’il y a « non pas simplement imitation des procédés, du genre ou du style d’un artiste, mais copie d’une œuvre déterminée de cet artiste » [9].

Ainsi, comme le rappelle la professeure Alexandra Bensamoun [10], le fondement le plus indiqué nous semble être celui du droit commun, de l’article 1240 du code civil, sur lequel un tribunal pourrait condamner les « créateurs » de ces textes et images imitant le style d’auteurs vivants à réparer le préjudice moral qu’ils ont subi, voire un préjudice économique dans des cas spécifiques d’usage parasitaire du style d’un auteur d’œuvres protégées.

Conclusion.

On le voit, l’irruption des créations de l’IA perturbe le droit de la propriété intellectuelle, dont les outils sont insuffisants pour répondre aux questionnements suscités. Mais les interrogations ne sont pas que juridiques. L’IA est aujourd’hui capable de battre des champions du monde d’échecs ou de go.

On peut imaginer que l’IA permettra un jour de produire de « fausses » sculptures de Camille Claudel, en s’adjoignant la technologie de l’impression 3D, ou encore de faire écrire à Rimbaud ou à Mozart des poèmes et des symphonies d’un niveau artistique approchant ou équivalent, qu’ils auraient pu écrire s’ils n’étaient pas morts si jeunes. Un avenir possible de l’art pourrait être dans la déshumanisation de la création, ce qui non seulement rendrait indispensable une modification du premier livre du CPI (ce qui pourrait se produire sous l’impulsion du règlement européen en discussion sur l’IA, l’« AI act » [11]) mais susciterait en outre des questionnements éthiques.

Si le public prend autant de plaisir à lire un roman écrit par une machine ou à admirer une exposition d’œuvres picturales créées par un logiciel [12], les professions artistiques survivront-elles à cette concurrence ?

Notes de l’article:

[1] « Intelligence artificielle : ces artistes qui en font leur big data », Libération, 30 décembre 2022.

[4] Article L. 113-1 du CPI

[6] « Illustrateurs et photographes concurrencés par l’intelligence artificielle : ‘‘Il n’y a aucune éthique’’ », Libération, 29 décembre 2022

[8] Laurent Saenko et Hervé Temime, Quel droit pénal pour le marché de l’art de demain ?, AJ Pénal 2020, p. 108 ; Christophe Caron, Droit d’auteur – la « contrefaçon hommage », Communication Commerce électronique n° 7-8, juillet 2021.

[9] Cour d’appel de Paris, 9 juin 1973, JCP 1974, II. 17883.

[10] « Intelligence artificielle : ‘‘Le droit d’auteur protège une création précise, mais pas une manière de créer’’, Libération, 31 décembre 2022, interview par Clémentine Mercier.